Webサイトの運営者にとって、SEO対策は非常に重要です。その一環として、robots.txtというファイルがあることをご存知でしょうか?Webサイトのクローラーに対して、どのページをクロールして良いか、またはクロールしないで欲しいかを指示するためのファイルが、robots.txtです。

このファイルを正しく設定することで、検索エンジンのクローラーに対して重要な情報を伝え、SEO効果を高めることができます。しかし、間違った設定をしてしまうと、逆にSEOにマイナスの影響を与えてしまう可能性もあります。

そこで本記事では、robots.txtとはどういうものか、SEO効果や設定方法など、Webサイト運営に必要な情報を網羅的に解説していきます。特に、クローラーとの関係性やSEOへの影響、正しい書き方のポイントを詳しく解説します。

記事執筆:認定SEOコンサルタント 三田健司

robots.txtの基本知識

robots.txtとは、Webサイトのクローラーやロボットに対して、特定のページやディレクトリにアクセスすることを制限するためのファイルです。このファイルは、Webサイトのルートディレクトリに配置され、クローラーがアクセスする前に読み取られます。

このファイルの目的は、Webサイトのオーナーがクローラーに特定のページやディレクトリへのアクセスを許可または禁止することができるようにすることです。例えば、WordPressのログインページなどは、一般的にクロールされないように設定されています。

robots.txtとは何か

robots.txtは単純なテキストファイルで、検索エンジンのクローラーがWebサイトにアクセスした際に最初に確認するファイルの一つです。サイトのルートディレクトリに配置することで、クローラーがサイト内のどの部分をクロールすべきか、またはクロールすべきでないかを指示します。

例えば、https://example.com/robots.txt のように、ドメインの直後に「/robots.txt」を付けることでアクセスできます。このファイルには、クローラーの動作を制御するためのルールが記述されています。

robots.txtの重要性

robots.txtファイルは、検索エンジン最適化(SEO)において重要な役割を果たします。特に大規模なWebサイトでは、クローラーがサイト内のコンテンツを効率的にクロールできるようにすることが重要です。

クローラーには「クロールバジェット」と呼ばれる制限があり、一定時間内にクロールできるページ数には限りがあります。robots.txtを適切に設定することで、重要なページを優先的にクロールしてもらい、不要なページをクロールから除外することができます。

これにより、検索エンジンが重要なコンテンツを見つけやすくなり、SEOの効果を高めることができます。また、サーバーリソースの消費を抑える効果もあります。

robots.txtを使うメリット

robots.txtファイルを適切に設定することで、いくつかの重要なメリットがあります。ここでは、robots.txtファイルがSEOにどのような効果をもたらすのか、そしてどのようなケースで使用すべきかを説明します。

SEO効果を高める設定

robots.txtファイルを正しく設定することで、SEOに以下のような良い効果をもたらします:

- クロールバジェットの最適化:不要なページをクロールから除外することで、検索エンジンが重要なページをより効率的に取得できます。

- インデックスの質の向上:品質の高いコンテンツを優先的にクロールしてもらうことで、検索エンジンのインデックスに登録されるコンテンツの質が向上します。

- サーバー負荷の軽減:不要なクロールを制限することで、サーバーのリソース消費を抑えることができます。

- クロールエラーの削減:クロールすべきでないページを明示することで、クロールエラーの発生を減らすことができます。

特定コンテンツへのクロールを制限する

robots.txtを使用して、以下のようなコンテンツへのクロールを制限することができます:

- 管理者ページ:管理画面やログインページなど、一般ユーザーには不要なページ

- 検索結果ページ:サイト内検索の結果ページなど、動的に生成されるページ

- 重複コンテンツ:同じ内容が複数のURLで表示されるページ

- プライベートコンテンツ:会員限定ページなど、非公開のコンテンツ

- リソースファイル:CSS、JavaScript、画像ファイルなど(ただし、これらをブロックするとサイトの表示に問題が生じる可能性があります)

このように、robots.txtファイルは、クローラーの動作を制御することで、SEOの効果を高めることができます。ただし、設定を誤ると逆効果になる可能性もあるため、慎重に設定する必要があります。

robots.txtの書き方

robots.txtファイルは、Webサイトのルートディレクトリに配置します。一般的には、https://example.com/robots.txtのようにアクセスできるようにすることが一般的です。ここでは、robots.txtファイルの基本的な書き方と主要な要素について説明します。

基本的な記述ルール

robots.txtの基本的な記述形式は以下の通りです:

User-agent: [クローラー名]

Disallow: [制限するページのパス]

例えば、Googleのクローラー(Googlebot)に対して、管理者ページへのアクセスを制限する場合は以下のように記述します:

User-agent: Googlebot

Disallow: /admin/

複数のクローラーに対して同じルールを適用する場合は、それぞれのUser-agentを指定する必要があります:

User-agent: Googlebot

Disallow: /admin/

User-agent: Bingbot

Disallow: /admin/

すべてのクローラーに対して同じルールを適用する場合は、アスタリスク(*)を使用します:

User-agent: *

Disallow: /admin/

重要な要素の解説

robots.txtファイルには、いくつかの重要な要素があります。ここでは、4つの主要な要素について詳しく説明します。

User-agent

User-agentは、ルールを適用するクローラーを指定するための要素です。主要なクローラーの例は以下の通りです:

- Googlebot:Google検索のクローラー

- Bingbot:Bing検索のクローラー

- Slurp Bot:Yahoo!検索のクローラー

- Baiduspider:Baidu検索のクローラー

すべてのクローラーに対してルールを適用する場合は、「User-agent: *」と指定します。

Disallow

Disallowは、クロールを禁止するURLパターンを指定します。例えば:

- 特定のディレクトリを禁止する場合:

Disallow: /admin/ - 特定のファイルを禁止する場合:

Disallow: /private.html - サイト全体を禁止する場合:

Disallow: / - 特定のファイル拡張子を持つファイルを禁止する場合:

Disallow: /*.pdf$

Allow

Allowは、Disallowで禁止されたパターンの中で、特定のURLパターンだけをクロール許可するために使用します。例えば:

User-agent: *

Disallow: /admin/

Allow: /admin/public/

この場合、「/admin/」ディレクトリは禁止されますが、「/admin/public/」ディレクトリは許可されます。

Sitemap

Sitemapは、サイトマップファイルの場所を指定するために使用されます。サイトマップは、クローラーがサイト内のすべてのページを効率的に見つけるためのファイルです。

Sitemap: https://example.com/sitemap.xml

サイトマップを指定することで、クローラーがサイト内のページを効率的に発見できるようになります。複数のサイトマップがある場合は、それぞれを別の行に記述します。

robots.txtの設定ステップ

robots.txtファイルを正しく設定するには、いくつかのステップがあります。ここでは、ファイルの作成からサーバーへのアップロードまでの手順を説明します。

テキストファイルの作成

まず、テキストエディタ(メモ帳やVisual Studio Codeなど)を使用して、robots.txtという名前のファイルを作成します。ファイル内に前述の書式に従ってルールを記述します。

例えば、基本的なrobots.txtファイルは次のようになります:

User-agent: *

Disallow: /admin/

Disallow: /private/

Disallow: /tmp/

Allow: /

Sitemap: https://example.com/sitemap.xml

このファイルは、すべてのクローラーに対して、「/admin/」、「/private/」、「/tmp/」ディレクトリへのアクセスを禁止し、それ以外のディレクトリへのアクセスを許可します。また、サイトマップの場所も指定しています。

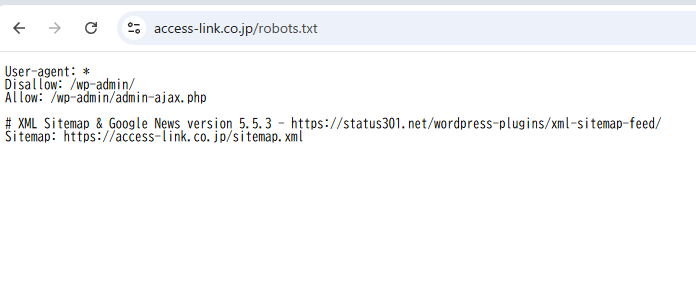

サーバーへのアップロード方法

robots.txtファイルを作成したら、FTPソフトウェアや管理パネルを使用して、Webサイトのルートディレクトリにアップロードします。ルートディレクトリとは、Webサイトの最上位のディレクトリで、一般的にはドメイン名(例:example.com)で直接アクセスできる場所です。

WordPressを使用している場合は、プラグインを使用してrobots.txtファイルを作成・編集することもできます。例えば、「Yoast SEO」や「All in One SEO」などのSEOプラグインには、robots.txtファイルを管理する機能が含まれています。

アップロード後は、Webブラウザで「https://example.com/robots.txt」(実際のドメイン名に置き換えてください)にアクセスして、ファイルが正しく表示されることを確認してください。

robots.txtとnoindexタグの違い

SEOの文脈では、robots.txtとnoindexタグはどちらもページの検索結果表示を制御する手段ですが、その仕組みと効果は大きく異なります。ここでは、それぞれの機能と効果的な使い分け方について説明します。

それぞれの機能と役割

robots.txtの機能

robots.txtは、クローラーがWebサイトのどの部分をクロールすべきか、またはクロールすべきでないかを指示するファイルです。主な特徴は以下の通りです:

- サイト全体または特定のディレクトリに対するクロール指示を行う

- クローラーがサイトにアクセスする前に確認される

- サイト全体に対する一元的な設定が可能

- クロールを禁止するだけで、インデックスからの除外を保証するものではない

noindexタグの機能

noindexタグは、HTMLのmeta要素またはHTTPレスポンスヘッダーとして実装され、特定のページを検索インデックスから除外するよう指示します:

- 個別のページに対して設定する

- クローラーがページをクロールした後に処理される

- ページごとに細かく制御できる

- インデックスからの除外を明示的に指示する

meta要素としてのnoindexタグの例:

<meta name="robots" content="noindex">

HTTPレスポンスヘッダーとしての例:

X-Robots-Tag: noindex

使い分けのポイント

robots.txtとnoindexタグの効果的な使い分けは以下の通りです:

- クロールを防止したいが、すでにインデックスされているページが検索結果に表示されても問題ない場合:

- robots.txtを使用

- 検索結果に表示されたくないページがある場合:

- noindexタグを使用

- 大量のページがあり、低品質・重要でないページのクロールを防ぎたい場合:

- robots.txtを使用して効率的にクロールバジェットを管理

- クロールは許可するが、検索結果への表示を防ぎたい場合:

- noindexタグを使用

- 一時的な文書や開発中のページがある場合:

- noindexタグを使用(将来的に検索結果に表示したい場合は、タグを削除するだけで良い)

以下の表は、robots.txtとnoindexタグの主な違いをまとめたものです:

| 特徴 | robots.txt | noindexタグ |

|---|---|---|

| 実装場所 | サイトのルートディレクトリ | 個別のHTMLページまたはHTTPヘッダー |

| 主な目的 | クロールの制御 | インデックスからの除外 |

| 適用範囲 | サイト全体または特定のディレクトリ | 個別のページ |

| 検索結果からの除外 | 保証なし | 明示的に指示 |

| 処理タイミング | クロール前 | クロール後 |

| 既存インデックスへの影響 | なし | あり(時間経過とともに除外される) |

robots.txtの確認とテスト

robots.txtファイルを設定した後は、正しく動作しているかを確認することが重要です。ここでは、動作確認の方法とエラーが発生した場合の対処方法について説明します。

動作確認の方法

1. ブラウザでの確認

最も簡単な確認方法は、Webブラウザで直接robots.txtファイルにアクセスすることです。 「https://example.com/robots.txt」(実際のドメイン名に置き換え)にアクセスして、意図したとおりの内容が表示されることを確認します。

2. Google Search Consoleの使用

Google Search Consoleには、robots.txtファイルをテストするためのツールが用意されています:

- Google Search Consoleにログインします。

- サイドバーメニューから「インデックス作成」→「robots.txtテスター」を選択します。

- 現在のrobots.txtファイルの内容が表示され、エラーがあれば通知されます。

- 特定のURLがrobots.txtによってブロックされているかどうかをテストすることができます。

3. オンラインツールの活用

いくつかのオンラインツールでもrobots.txtファイルの検証が可能です:

- Technicalseo.com robots.txt Tester

- SEObook Robots.txt Analyzer

- Merkle’s robots.txt testing tool

これらのツールを使用すると、robots.txtファイルの構文エラーや潜在的な問題を検出することができます。

エラー処理について

robots.txtファイルの設定中に遭遇する可能性のある一般的な問題とその解決策は以下の通りです:

1. 構文エラー

robots.txtファイルの構文が正しくない場合、クローラーはファイル全体を無視するか、エラーのある部分を無視する可能性があります。

解決策:

- 各行が正しい形式であることを確認する

- 大文字と小文字の使用に注意する(User-agent、Disallow、Allowなど)

- 不要な空白やタブを削除する

2. ファイルが見つからない(404エラー)

robots.txtファイルがルートディレクトリに存在しない場合、クローラーはサイト全体をクロールしようとします。

解決策:

- ファイルがルートディレクトリにあることを確認する

- ファイル名が「robots.txt」(すべて小文字)であることを確認する

- サーバーの設定でファイルへのアクセスが許可されているか確認する

3. アクセス権限の問題(403エラー)

サーバーの設定によっては、robots.txtファイルにアクセスできない場合があります。

解決策:

- ファイルのパーミッションを確認する(通常は644)

- サーバーの.htaccessファイルで制限がないか確認する

4. 文字コードの問題

ファイルが正しくない文字コードで保存されていると、読み取れない可能性があります。

解決策:

- ファイルをUTF-8またはASCII形式で保存する

- 特殊文字やBOMマーカーを避ける

robots.txt設定時の注意点

robots.txtファイルを設定する際には、いくつかの重要な注意点があります。これらの点に注意しないと、SEOに悪影響を与える可能性があります。

クロール制限の影響

robots.txtファイルでページをクロール禁止に設定すると、検索エンジンはそのページの内容を確認できなくなります。これにより、以下のような影響があります:

- インデックスへの影響:クロール禁止にしても、そのページが検索結果から完全に削除されるわけではありません。タイトルやアンカーテキストなどの限られた情報だけで検索結果に表示される可能性があります。

- リンクジュースの分散:クロール禁止になったページに内部リンクを設定していても、そのリンクの効果が正しく伝わらない可能性があります。

- クロールバジェットの無駄:不適切なクロール制限を設定すると、クローラーの効率が低下し、重要なページがクロールされない可能性があります。

ユーザーアクセス制御の限界

robots.txtファイルは、クローラーのアクセスのみを制御するものであり、一般ユーザーのアクセスを制限するものではありません。以下の点に注意してください:

- セキュリティとしての限界:robots.txtファイルでクロール禁止にしても、一般ユーザーはそのページにアクセスできます。セキュリティ対策としては不十分です。

- 機密情報の扱い:機密情報やプライベートな情報は、robots.txtファイルだけでなく、適切なアクセス制御(パスワード保護など)を実装する必要があります。

- robots.txtファイルの公開:robots.txtファイル自体が公開されており、誰でも閲覧できます。そのため、サイト構造に関する情報が漏れる可能性があります。

以下は、robots.txt設定時の一般的な間違いと、それを避けるためのヒントです:

| 一般的な間違い | 推奨される対応 |

|---|---|

| 全サイトをクロール禁止にする | 必要な部分のみをクロール禁止にする |

| インデックス禁止の目的でrobots.txtを使用する | インデックス禁止にはnoindexタグを使用する |

| CSS・JSファイルをクロール禁止にする | モダンなSEOでは、CSSやJSファイルのクロールを許可する |

| 重要なページをクロール禁止にする | 検索結果に表示したいページはクロール許可にする |

| サイトマップを指定しない | Sitemapディレクティブを使用してサイトマップを指定する |

WordPressにおけるrobots.txtの設定

WordPressはWeb上で最も広く使われているCMSの一つです。ここでは、WordPressサイトでrobots.txtファイルを設定する方法について説明します。

便利なプラグインの活用法

WordPressでは、プラグインを使用することで、簡単にrobots.txtファイルを作成・編集することができます。以下は、人気のあるプラグインとその使用方法です:

1. Yoast SEO

Yoast SEOは、WordPress用の人気SEOプラグインで、robots.txtファイルの編集機能も提供しています:

- WordPressの管理画面からYoast SEOをインストールして有効化します。

- 「SEO」→「ツール」→「ファイルエディター」を選択します。

- robots.txtタブを選択し、内容を編集します。

- 「変更を保存」をクリックします。

2. All in One SEO Pack

All in One SEO も、robots.txtファイルの編集機能を提供しています:

- WordPressの管理画面からAll in One SEO Packをインストールして有効化します。

- 「All in One SEO」→「ツール」→「robots.txt エディター」を選択します。

- robots.txtファイルの内容を編集します。

- 「変更を保存」をクリックします。

標準機能での設定方法

プラグインを使用せずに、WordPressの標準機能でrobots.txtファイルを設定することもできます:

1. 物理的なファイルの作成

- テキストエディタでrobots.txtファイルを作成します。

- FTPソフトウェアを使用して、WordPressのルートディレクトリ(通常はpublic_htmlまたはwwwフォルダ)にファイルをアップロードします。

2. functions.phpを使用する方法

WordPressのテーマのfunctions.phpファイルを編集して、robots.txtファイルを動的に生成することもできます:

add_action('do_robots', 'custom_robots');

function custom_robots() {

echo "User-agent: *\n";

echo "Disallow: /wp-admin/\n";

echo "Disallow: /wp-includes/\n";

echo "Allow: /wp-admin/admin-ajax.php\n";

echo "Sitemap: " . home_url('/sitemap.xml') . "\n";

}

このコードをテーマのfunctions.phpファイルに追加すると、WordPressは自動的にカスタムのrobots.txtファイルを生成します。

robots.txtの更新と管理

robots.txtファイルは、一度設定して終わりではなく、定期的な見直しと更新が必要です。ここでは、効果的な管理方法と最新のSEO事情に基づいた更新のポイントについて説明します。

定期的な見直しの重要性

robots.txtファイルは、以下のタイミングで定期的に見直すことが重要です:

- サイト構造の変更時:ディレクトリ構造や重要なページの変更があった場合、robots.txtファイルも更新する必要があります。

- サイトリニューアル時:サイトのリニューアルを行う際は、robots.txtファイルの設定も見直し、新しい構造に合わせて更新します。

- 検索エンジンのアルゴリズム更新後:検索エンジンのアルゴリズムが大きく更新された場合、robots.txtの最適な設定も変わる可能性があります。

- クロールエラーの発生時:Google Search Consoleなどでクロールエラーが報告された場合、robots.txtファイルの設定を見直す必要があるかもしれません。

- 定期的な監査:少なくとも3ヶ月に1回程度、robots.txtファイルの設定を見直すことをお勧めします。

最新のSEO事情と管理運用上の注意点

最新のSEO事情に基づいたrobots.txtファイルの管理運用上の注意点は以下の通りです:

- モバイルファーストインデックス:Googleは現在、モバイルファーストインデックスを採用しています。モバイルサイトとデスクトップサイトが異なる場合は、それぞれのrobots.txtファイルの整合性を確認してください。

- JavaScriptとCSSの処理:現代の検索エンジンはJavaScriptとCSSファイルをクロールして、ページの表示方法を理解しようとします。これらのファイルをクロール禁止にすると、SEOに悪影響を与える可能性があります。

- クローラーの多様化:Googlebot以外にも、様々なクローラーがWebサイトにアクセスします。主要なクローラーに対して適切な設定を行うことが重要です。

- ログ分析の活用:サーバーのアクセスログを分析して、クローラーの動きを監視することで、robots.txtファイルの効果を確認することができます。

- バージョン管理の導入:robots.txtファイルの変更履歴を管理することで、問題が発生した場合に以前の設定に戻すことができます。

以下は、効果的なrobots.txt管理のためのチェックリストです:

| 項目 | 確認内容 |

|---|---|

| 構文チェック | robots.txtファイルの構文にエラーがないか確認 |

| クロール状況 | Google Search Consoleでクロールの状況を確認 |

| アクセスログ | サーバーのアクセスログでクローラーの動きを確認 |

| ディレクトリ構造 | サイトのディレクトリ構造とrobots.txtの設定の整合性を確認 |

| サイトマップ | サイトマップのURLが正しく指定されているか確認 |

| 重要ページ | 重要なページがクロール禁止になっていないか確認 |

| クローラー別設定 | 主要なクローラーに対して適切な設定がされているか確認 |

ログ監視とセキュリティ対策

robots.txtファイルの効果的な管理には、ログ監視とセキュリティ対策も重要です。ここでは、クローラーのアクセスログの監視方法とセキュリティリスクへの対応について解説します。

クローラーアクセスログの監視と分析

クローラーのアクセスログを監視することで、robots.txtファイルの効果を確認し、必要に応じて最適化することができます:

- アクセスログの確認方法:

- サーバーのアクセスログファイル(通常は「access.log」)を確認します。

- ログ分析ツール(例:AWStats、Webalizer)を使用して、クローラーのアクセス状況を分析します。

- Google Search ConsoleやBing Webmaster Toolsなどのツールで、クロール統計を確認します。

- クローラーの識別:

- User-Agentをチェックして、どのクローラーがアクセスしているかを識別します。

- IPアドレスを確認して、正規のクローラーかどうかを検証します。

- クロールパターンの分析:

- クローラーがどのページをどのような頻度でクロールしているかを分析します。

- クロールされているページと、クロールされていないページの違いを確認します。

- エラーパターンの検出:

- 404エラー(ページが見つからない)や500エラー(サーバーエラー)が多発しているページがないか確認します。

- robots.txtファイルの設定が原因でエラーが発生していないか確認します。

セキュリティリスクと対策

robots.txtファイルはセキュリティ対策としては不十分であり、以下のリスクと対策を理解しておく必要があります:

- 情報漏洩のリスク:

- robots.txtファイルにはサイトの構造が記述されており、攻撃者に情報を与える可能性があります。

- 機密情報や重要なディレクトリの名前を直接記述することは避けるべきです。

- 推測攻撃の防止:

- robots.txtファイルで禁止しているディレクトリは、攻撃者が興味を持つ可能性があります。

- 重要なディレクトリには、適切なアクセス制御(パスワード保護、IPアドレス制限など)を実装する必要があります。

- 適切なセキュリティ対策:

- robots.txtファイルだけでなく、.htaccessファイルやWeb Application Firewall(WAF)などの仕組みを組み合わせてセキュリティを高めます。

- 定期的なセキュリティ監査を実施して、脆弱性がないか確認します。

- 開発環境と本番環境の分離:

- 開発環境と本番環境で異なるrobots.txtファイルを使用することで、開発中のコンテンツが誤ってクロールされるリスクを軽減します。

- 開発環境では、すべてのクローラーを禁止するrobots.txtファイルを使用することが一般的です。

まとめと今後の展望

本記事では、robots.txtファイルの基本知識からSEO効果、設定方法、注意点まで詳しく解説しました。ここでは、記事の内容を振り返りつつ、今後のSEOにおけるrobots.txtファイルの重要性について考察します。

SEO施策におけるrobots.txtの役割

robots.txtファイルは、SEO施策において以下のような重要な役割を果たします:

- クロールの最適化:robots.txtファイルを適切に設定することで、検索エンジンのクローラーが重要なページを効率的にクロールできるようになります。特に大規模なWebサイトでは、クロールバジェットを効率的に使用するために重要です。

- インデックスの質の向上:不要なページや低品質なページをクロール対象から除外することで、検索エンジンのインデックスに登録されるコンテンツの質が向上します。

- サーバーリソースの節約:クロールの頻度や対象を制御することで、サーバーのリソース消費を抑えることができます。特にトラフィックの多いサイトやリソースの限られたサーバーでは重要です。

- サイト構造の明確化:robots.txtファイルとサイトマップを組み合わせることで、サイトの構造を検索エンジンに明確に伝えることができます。

今後の検索エンジンの動向を考える

検索エンジンの技術は日々進化しており、robots.txtファイルの活用方法も変化しています。以下は、今後の展望です:

- AIの進化:検索エンジンのAI技術の進化により、robots.txtファイルの解釈やクロールの判断が高度化すると予想されます。より複雑なパターンマッチングや文脈の理解が可能になるでしょう。

- 新しい標準の登場:現在のrobots.txtの仕様は1994年に策定されたものですが、将来的にはより高度な制御が可能な新しい標準が登場する可能性があります。

- モバイルとデスクトップの統合:モバイルファーストインデックスの普及により、モバイルサイトとデスクトップサイトの区別がさらに薄れ、robots.txtファイルの設定も統一されていく傾向があります。

- 動的コンテンツへの対応:SPAやJavaScriptを多用したWebサイトの増加に伴い、robots.txtファイルの解釈や動的コンテンツのクロール方法が変化していく可能性があります。

- プライバシーとセキュリティの強化:プライバシー規制の強化に伴い、個人情報を含むページの扱いや、robots.txtファイルのセキュリティ面での役割が重要になるでしょう。

以上がrobots.txtファイルに関する総合的な解説です。適切な設定を行うことで、サイトのSEO効果を高め、ユーザーエクスペリエンスの向上にもつながります。定期的に見直し、最新のSEO事情に合わせて適切に管理していくことが重要です。

記事執筆・株式会社アクセス・リンク 代表取締役

Webサイト制作歴10年以上の経験を元にSEOコンサルティングを行い、延べ1,000件以上のサポート実績を誇ります。個人事業主や中小企業向けのホームページ制作やSEOコンサルティングを得意としています。

(社)全日本SEO協会 認定SEOコンサルタント

コメント